Norint užtikrinti, kad Jūsų svetainė būtų tinkamai nuskaitoma arba blokuojama paieškos sistemų robotų pagal Jūsų norus, labai svarbu tinkamai sukonfigūruoti robots.txt failą. Nuo 2024 m. spalio 7 d. „Google“ įvedė naujas taisykles, kurios keičia, kaip robotai interpretuoja šį failą. Dabar robotai taiko tiksliausią taisyklių grupę kiekvienam user-agent’ui, taip pat sujungdami kelių grupių taisykles, jei jos taikomos tam pačiam robotui.

Kas yra robots.txt failas?

Robots.txt – tai paprastas tekstinis failas, kuris nurodo, kurie svetainės puslapiai gali būti indeksuojami arba ignoruojami paieškos variklių robotų. Pavyzdžiui, jei nenorite, kad tam tikra svetainės dalis būtų nuskaitoma, galite naudoti komandą „Disallow“:

User–agent: *

disallow: /private/

Šis pavyzdys blokuoja visiems robotams prieigą prie „/private/“ aplanko. Tačiau jei norite, kad „Googlebot“ galėtų nuskaityti šiuos failus, galite pridėti kitą taisyklę:

User–agent: Googlebot

allow: /private/

Taip sukuriate išimtis konkrečiam paieškos robotui.

Robots.txt vieta serveryje

Svarbu, kad robots.txt failas būtų patalpintas pagrindiniame svetainės kataloge (pavyzdžiui, https://easyseo.lt/robots.txt). Failas turi galioti tik tam pačiam domenui, protokolui kur jis yra patalpintas.

Taisyklės

Galite nurodyti konkrečius robotus, kuriems taikysite taisykles (naudojant „User-agent“), o taip pat nurodyti „Disallow“ ir „Allow“ komandas. Sitemap komanda gali būti naudojama, kad paieškos sistemos lengviau rastų Jūsų svetainės žemėlapį:

Sitemap: https://easyseo.lt/sitemap_index.xml

Svarbiausi niuansai

- Taisyklės galioja tik konkrečiam protokolui, www schemai ir domenui.

- Kai robotai negali pasiekti robots.txt dėl klaidų (pvz., 5xx atsakymo kodo), „Googlebot“ laikinai interpretuoja, kad svetainė yra visiškai užblokuota, kol gaunama kitokia informacija.

Jeigu Jūsų svetainė turi sudėtingas struktūras, svarbu suprasti, kaip „Googlebot“ interpretuoja robots.txt pagal Google naujas taisykles. Nuoroda į pilną gidą iš Google bus teksto apačioje.

Sintaksė

Tinkamos robots.txt failo eilutės sudarytos iš lauko, dvitaškio ir nurodymo. Tarpai nėra privalomi, bet rekomenduojami, kad būtų aiškiau. Tarpai pradžioje ir pabaigoje ignoruojami. Norėdami pridėti komentarą, naudokite „#“, o visa informacija po šiuo simboliu bus ignoruojama. Bendras formatas: <laukas>:<nurodymas> <#neprivalomas-komentaras>.

Google palaiko šiuos laukus (kiti laukai, tokie kaip crawl-delay, nėra palaikomi):

user-agent: identifikuoja robotą, kuriam taikomos taisyklėsallow: nurodo URL, kurį galima nuskaitytidisallow: nurodo URL, kurio negalima nuskaitytisitemap: svetainės medžio URL

Kas naujo nuo 2024 m. Spalio?

Pagrindinės naujienos iš „Google“ teksto apie robots.txt taisyklių atnaujinimus:

- Grupavimas: Taisyklės dabar sujungiamos į vieną grupę kai vienam user-agent taikomi keli aprašymai, užtikrinant, kad robotai laikytųsi vienodų taisyklių.

- 404 ir 5xx klaidų tvarkymas: Jei robots.txt failas nėra pasiekiamas dėl 404 klaidos, laikoma, kad nėra jokių apribojimų. Jei gaunama 5xx klaida, robotai laikinai blokuoja nuskaitymą.

- Wildcard taisyklės: Naudojami simboliai „*“ ir „$“ taisyklėse leidžia lankstesnį URL filtravimą.

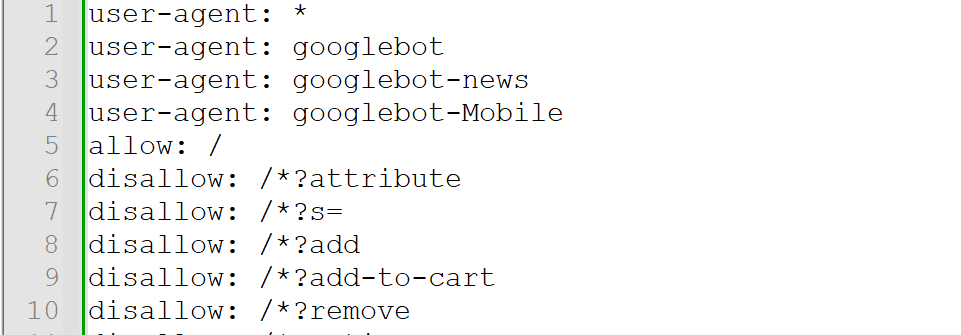

User-agent grupavimas

Šis pakeitimas leidžia robotams apjungti visas taisykles, taikomas tam pačiam user-agent. Tai reiškia, kad jei svetainėje yra kelios grupės su skirtingomis taisyklėmis tam pačiam robotui, taisyklės bus apjungtos. Svetainės savininkai gali sudaryti tikslesnes ir universalesnes taisykles, sumažinant taisyklių prieštaravimus.

404 ir 5xx klaidų tvarkymas

Jei robots.txt failas nepasiekiamas dėl 404 klaidos, robotai manytų, kad nėra svetainės nuskaitymo apribojimų. Tai naudinga, jei failas netyčia pašalintas.

5xx klaidos laikinai blokuoja visos svetainės nuskaitymą.

Wildcard taisyklės

Leidžia lanksčiau filtruoti URL adresus. Simbolis „*“ apima kelis simbolius, o „$“ nurodo URL pabaigą. Tai leidžia tiksliau blokuoti ar leisti robotams pasiekti tam tikrus puslapius, pvz., failų tipus ar katalogus.

Klaidos ir HTTP statuso kodai

Kai „Google“ robotai aplanko robots.txt failą, serverio atsakymo HTTP statuso kodas nulemia, kaip šis failas bus naudojamas. Kiekvienas statuso kodas turi skirtingą įtaką nuskaitymui: sėkmingas 2xx kodas leis apdoroti failą, o nukreipimai (3xx) arba klaidos (4xx, 5xx) gali sustabdyti arba apriboti nuskaitymą. Lentelėje pateikiama, kaip „Googlebot“ traktuoja robots.txt failus pagal skirtingus HTTP atsakymo kodus.

Nuo spalio m. 2024 metų Google interpretuos robots.txt failo statusą pagal naujas taisykles:

| Klaidų tipas | Aprašymas |

|---|---|

| 2xx (sėkmė) | HTTP statuso kodai, kurie rodo sėkmę, leidžia „Google“ robotams apdoroti *robots.txt* failą taip, kaip jį pateikė serveris. |

| 3xx (nukreipimai) | „Google“ seka iki 5 nukreipimų, po kurių failas laikomas 404 klaida. Loginiai nukreipimai (rėmai, JavaScript) ignoruojami. |

| 4xx (kliento klaidos) | Visos 4xx klaidos, išskyrus 429, laikomos, kad *robots.txt* failo nėra, o tai reiškia, kad nėra nuskaitymo apribojimų. |

| 5xx (serverio klaidos) | 5xx ir 429 klaidos laikinai interpretuojamos kaip visiškas svetainės blokavimas. „Google“ bandys iš naujo gauti failą, kol gaus tinkamą atsakymą. |

| Kitos klaidos | DNS ar tinklo problemos (laiko pabaigos, netinkami atsakymai) laikomos serverio klaidomis kai *robots.txt* nepasiekiamas. |

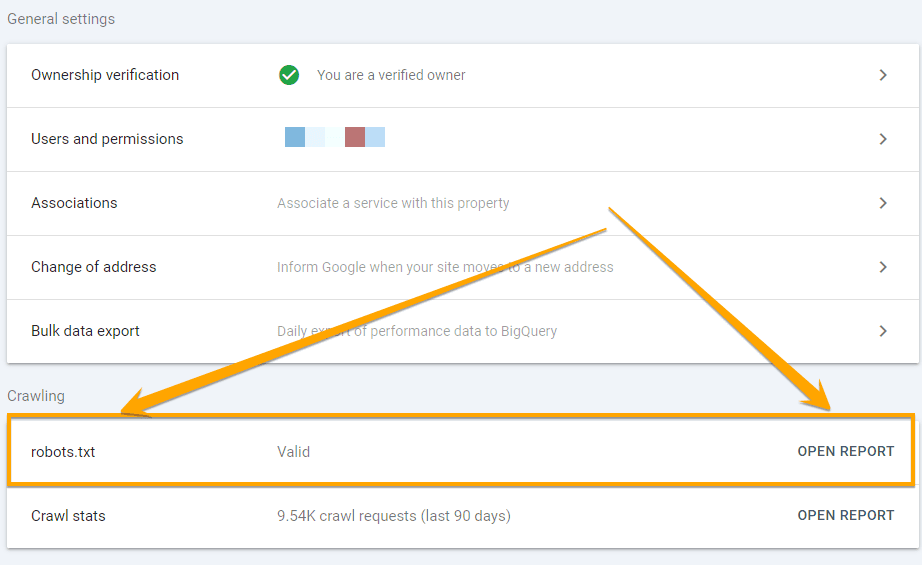

Kur pamatyti robots.txt failo būklę?

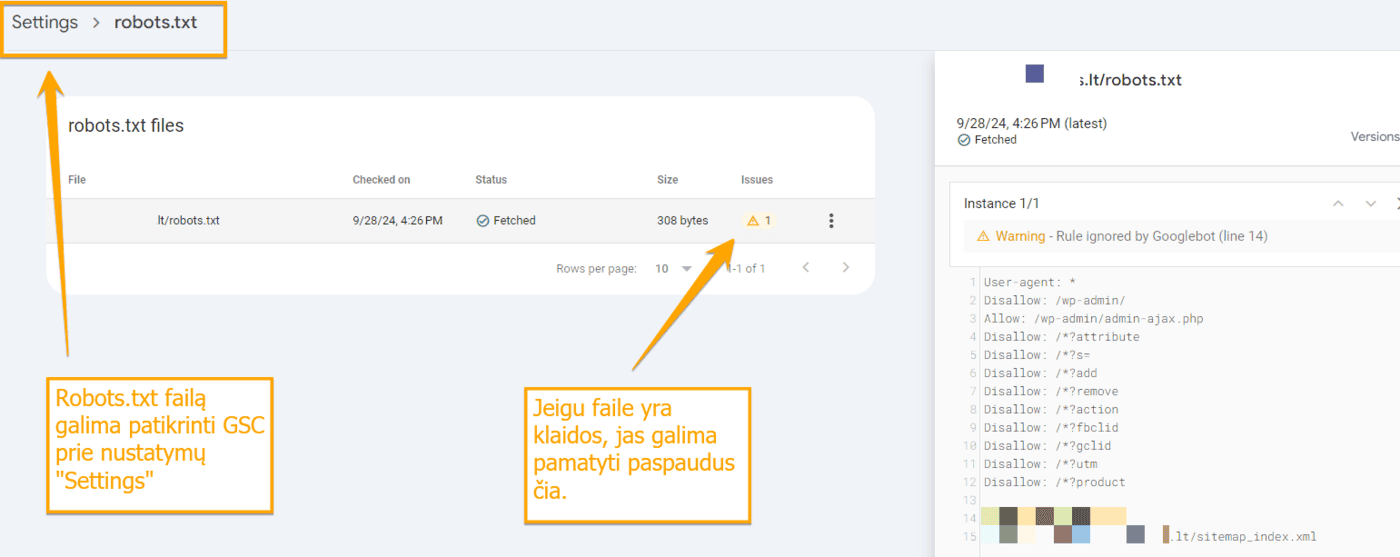

Robots.txt failo būklę galima sužinoti Google paieškos konsolėje (GSC). Konsolėje reikia surasti Settings → Crawling ir paspausti ant ataskaitos „Open report”

Žemiau ataskaitos pavyzdyje yra parodyta, kad robots.txt failas turi klaidų. Klaidas galima pamatyti paspaudus ant trikampio prie „Issues”

*Šaltinis: https://developers.google.com/search/docs/crawling-indexing/robots/robots_txt

Jeigu jums reikia pagalbos su Jūsų tinklapio robots.txt failu, kreipkte į EASYSEO.

Reikia SEO mokymų Jūsų komandai ar įmonei? Spauskite čia →